斯坦福大学和英伟达(Nvidia)的研究团队研发的 3D GAN 能够生成更好的合成人图像,并且是 3D 重建的。论文《EG3D:高效的几何感知 3D 生成对抗网络》(EG3D: Efficient Geometry-aware 3D Generative Adversarial Networks)展示了这一成果。

GAN(生成式对抗网络)现在能生成人、动物、山脉、海滩和食物的逼真图像。但是,即使是最强大的系统,如来自 Nvidia 的 StyleGAN,也无法在当前硬件上使用 3D 表示。3D 表示有两个优点:有助于从不同角度生成合成人的多个图像,并且可以将它们作为人的 3D 模型的基础。而在传统的 2D-GAN 中,来自同一合成人的不同视角的图像通常会显示出表示的变化:有时耳朵不一样,嘴角扭曲或眼睛周围的区域看起来不协调。尽管英伟达最新的 StyleGAN 变体 StyleGAN3 取得了更大的稳定性,但结果仍远非自然。网络不存储 3D 信息,因此无法从多个角度保持显示稳定。

谷歌的神经辐射场(NeRFs)等其他方法可以学习 3D 表示,然后在显示中生成具有高稳定性的新视角。NeRF 依赖于神经网络,其中在训练期间形成了学习对象的隐式 3D 表示。学习隐式表示的替代方法是体素网格的显式表示。

神经网络中的隐式表示与体素网格等 3D 系统中的显式表示各有优点和缺点:体素网格的视角请求处理速度很快,而使用 NeRF 可能需要数小时,具体取决于架构。体素网格在高分辨率下非常需要内存,而 NeRF 由于其作为函数的隐式 3D 表示而更具有内存效率。

斯坦福大学和英伟达的研究团队结合显式和隐式表示,研发出了一种混合方法,能够快速有效地扩展分辨率。该团队依赖于三个级别的 3D 表示,而不是完整的体素网格。三级模块连接在 StyleGAN2 生成器网络后面,并存储生成器的输出。神经渲染器解码存储的信息并将其传递给超分辨率引擎。这能将 128 x 128 像素的图像放大到 512 x 512 像素,而且图像还包含三个级别中表示的深度信息。

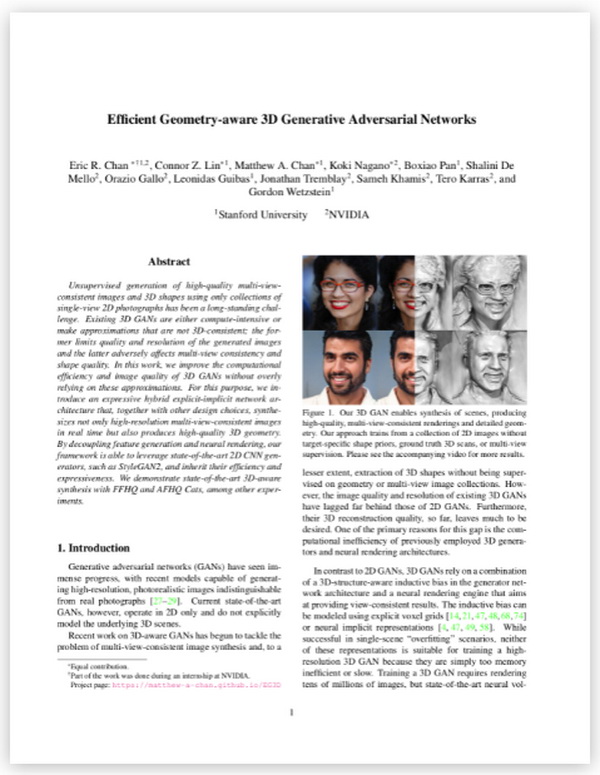

结果是一个 3D GAN,它可以生成一致的图像,例如,一个人从不同角度的图像和一个 3D 模型。EG3D 还可以从单个图像生成匹配的 3D 重建,因此结果的质量超过了其他 GAN 以及其他方法(例如 NeRF)。

研究人员指出了个别牙齿等细节的局限性,并计划改进他们的人工智能。也可以交换单个模块并转换系统,例如,通过文本有针对性地生成图像。由于基于单个图像的 3D 重建可能会被用于深度伪造(Deepfakes),研究团队警告不要滥用 EG3D。【本文最初发布于反讽机器】