Meta 研发的新 AI 系统“Make-a-Video”可以由文本、图像生成短视频,也可以改变现有视频的细节来生成新的视频。

今年 6 月份,Meta 推出了“Make-a-Scene”,这一多模态 AI 系统可以由描述场景布局的文本和非常粗略的草图生成图像。Make-a-Video 是对这种运动图像系统的进一步发展:除了文本-图像对之外,Meta 还用未标记的视频数据训练了 AI。

“该系统从成对的文本-图像数据中学习世界的样子,以及世界如何在没有相关文本的视频片段中移动的。”Meta 研究团队写道。

据介绍,消除标记的视频数据减少了训练开销。与文本-图像对的结合使系统能够保留当前生成图像模型的视觉多样性,并了解单个对象的外观和引用方式。研究团队使用的是公开可用的图像和视频数据集。

与 AI 图像生成器一样,Make-a-Video 支持不同的样式,例如创建风格化或照片级真实感视频的功能。该系统还可以处理以单个图像作为输入并将它们设置为运动,或者在两个相似的图像之间创建运动。例如,将一张静止的家庭照片变成了一个短的家庭视频。

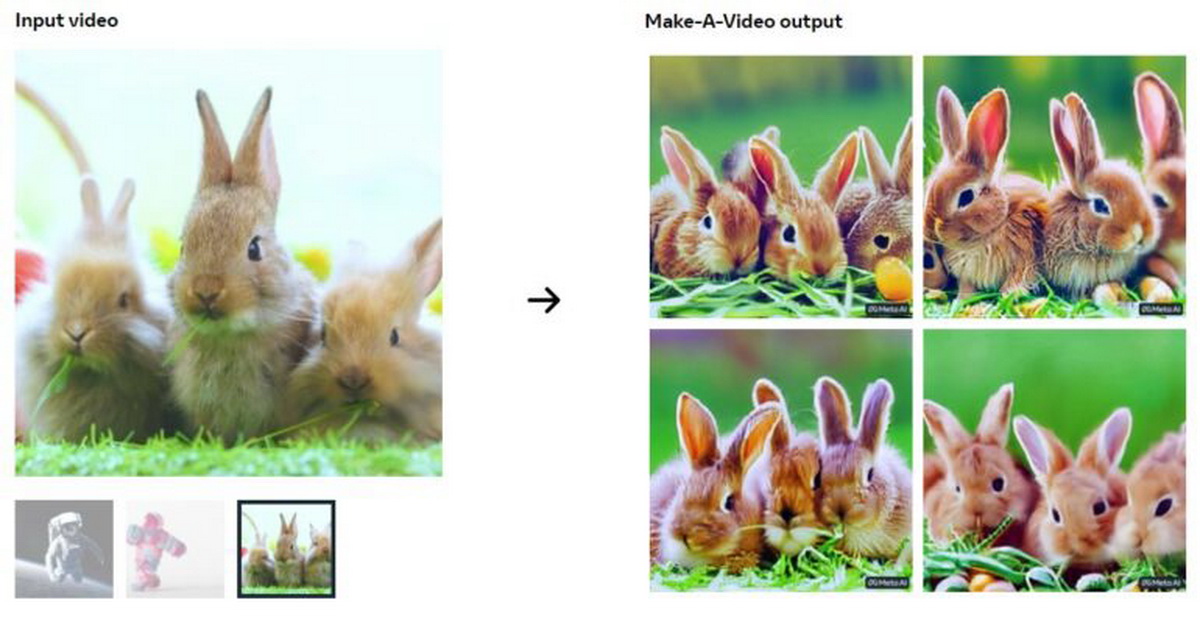

从现有的视频中,Make-a-Video 可以生成基于原始主题和动画的变体,但最终在细节上存在显着差异。

从质量上讲,Make-a-Video 生成的视频仍有显而易见的缺点,例如模糊或失真。但是,图像 AI 起初也存在这样的缺陷。根据 Meta 的数据,在最初的用户测试中,Make-a-Video 在文本输入表示和图像质量方面的评分都比可比系统好三倍。

根据 Meta 研究团队的说法,Make-a-Video 还不能将文本和只能在视频中看到的现象联系起来。此外,该系统还不能生成更长的场景来讲述细节丰富的连贯的故事。

研究人员指出,像所有大型生成 AI 系统一样,Make-a-Video 也从训练数据中继承了社会偏见,有时甚至是有害的偏见,并可能放大它们。为此,他们从数据中删除了 NSFW 的内容和有毒术语,并加入了过滤系统。他们还表示,所有训练数据都是公开的,以实现最大的透明度。使用 Make-a-Video 生成的所有场景都带有水印,以这是 AI 生成的视频。

Meta 宣布将发布一个公开的演示,但没有给出时间框架。目前,该模型仅在内部进行分析和测试,以确保可能发布的每个步骤都是“安全和有益的”。【数字叙事 Lighting】